DDoS: Dauerhafte Datenflut ohne Schutzstrategie – und wie man sich davor schützen kann

DDoS: Dauerhafte Datenflut ohne Schutzstrategie – und wie man sich davor schützen kann

Die Bedrohungslandschaft rund um Webanwendungen und IT-Systeme wird immer raffinierter. Während traditionelle Angriffe wie SQL-Injections, Cross-Site-Scripting und Session Hijacking auch 2025 nach wie vor aktiv sind, konnten sie durch moderne Web-Frameworks, Web-Application-Firewalls (WAF) und die Einhaltung von Best Practices deutlich eingedämmt werden.

Doch haben Sie schon einmal von Angriffen gehört, bei denen es nicht darum geht, vertrauliche Daten zu stehlen oder zu manipulieren? Es gibt auch Attacken, die einzig und allein darauf abzielen, IT-Systeme so lange wie möglich außer Betrieb zu setzen und den Schaden bei den Betroffenen zu maximieren.

In diesem Artikel betrachten wir eine solche böswillige Angriffsmethode, die im Jahr 2013 mit den Lastspitzen auf spamhaus.org eine neue Dimension erreichte. 5 Jahre später erlebte GitHub einen DDoS-Angriff mit einer schier unglaublichen Datenrate von 1,35 Tbit/s. Solche Angriffe sind keine Einzelfälle – jedes Unternehmen oder jede Organisation könnte schon morgen betroffen sein.

Was sind DDoS-Angriffe?

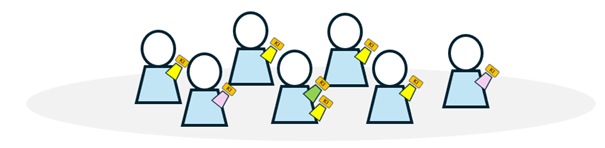

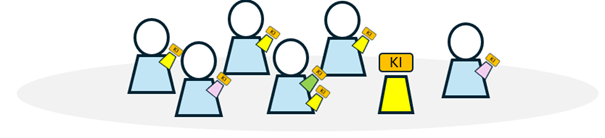

DDoS steht für Distributed Denial of Service und beschreibt eine Angriffstechnik, bei der eine enorme Anzahl an Paketen oder Anfragen gleichzeitig auf ein Zielsystem gesendet wird, um dessen Verfügbarkeit stark zu beeinträchtigen oder das System zum Absturz zu bringen. Im Gegensatz zum klassischen DoS (Denial of Service) verwendet DDoS eine Gruppe von kompromittierten Computern, statt nur eines einzelnen Rechners.

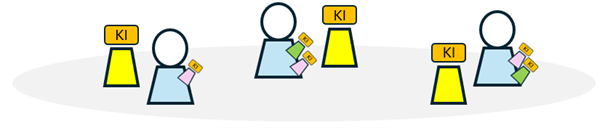

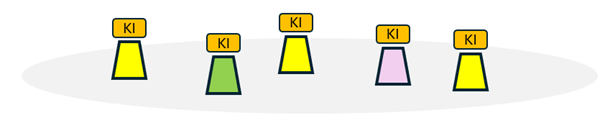

DDoS-Angriffe können auf unterschiedlichen Ebenen des weit verbreiteten OSI-Modells erfolgen, was zu einer Vielzahl an Angriffsmöglichkeiten führt. Diese können grob in zwei Kategorien unterteilt werden: stumpfe Angriffe und intelligente Angriffe, je nachdem, welche Ebene des OSI-Modells das Ziel darstellt.

Angriffsmethoden: Von einfach bis raffiniert

1) SYN-Flood-Angriff

Ein häufig eingesetzter Angriff ist die SYN-Flood-Attacke, die auf der Transportebene (Layer 4) durchgeführt wird. Dabei missbraucht der Angreifer den TCP-Drei-Wege-Handshake, der beim Verbindungsaufbau zwischen zwei Rechnern verwendet wird. Der Angreifer sendet zahlreiche SYN-Pakete mit gefälschten Quell-IP-Adressen an den Server, der diese mit SYN-ACK-Paketen beantwortet. Da der letzte Schritt des Handshakes (ACK vom Client) ausbleibt, bleiben die Verbindungen offen und überlasten das System. Solche Angriffe sind relativ einfach durchzuführen und können durch Techniken wie SYN-Cookies abgewehrt werden.

2) DNS-Verstärkung (DNS Reflection / Amplification)

Eine weitaus raffiniertere und schwerer zu entdeckende Angriffsmethode ist die DNS-Verstärkung. Bei dieser Methode wird das Zielsystem mit DNS-Antworten von seriösen DNS-Servern überflutet, die es jedoch nie angefragt hat. Kompromittierte Computer in einem Botnetz nutzen öffentlich zugängliche DNS-Server, um Anfragen zu stellen, deren Antworten dann über gefälschte Quell-IP-Adressen an das Ziel weitergeleitet werden. Das resultierende Datenvolumen ist häufig extrem hoch und kann das Zielsystem schnell überlasten. Im Fall des Angriffs auf spamhaus.org führte dies zu erheblichen Störungen im weltweiten Netzwerkverkehr.

Der Schaden durch DDoS-Angriffe

Ob einfache Flutattacken oder raffinierte DNS-Verstärkungsangriffe – der Schaden durch DDoS-Attacken kann enorm sein. Neben unmittelbaren Umsatzverlusten und Wiederherstellungskosten können auch Reputationsschäden und Rechtskosten erhebliche finanzielle Folgen haben.

Schutzmaßnahmen gegen DDoS-Angriffe

Um sich gegen DDoS-Angriffe zu schützen, ist es wichtig, proaktive Schutzstrategien zu entwickeln. Hier sind einige wesentliche Maßnahmen:

1) Priorisieren Sie kritische Dienste

Bestimmen Sie, welche Dienste für Ihr Unternehmen unverzichtbar sind, wie Webanwendungen, E-Mail-Server oder Datenbanken, und stellen Sie sicher, dass diese priorisiert geschützt werden.

2) Nutzen Sie spezialisierte DDoS-Schutzdienste

Setzen Sie auf Dienste wie Cloudflare oder Akamai, die Ihre Infrastruktur vor Angriffen schützen und den Traffic filtern können.

3) Implementieren Sie Intrusion Detection Systeme (IDS)

Verwenden Sie IDS und zentralisierte Logauswertung, um Anomalien frühzeitig zu erkennen und auf DDoS-Angriffe reagieren zu können.

4) Erstellen Sie eine DDoS-Reaktionsstrategie

Entwickeln Sie eine DDoS-Reaktionsstrategie und schulen Sie Ihr Team, damit alle wissen, wie im Fall eines Angriffs zu handeln ist. Regelmäßige Tests stellen sicher, dass der Plan funktioniert.

5) Betreiben Sie kritische Systeme an einem separaten Internet-Uplink

Betriebssysteme, die kritisch sind, sollten an einem anderen Internet-Uplink betrieben werden, um sie gezielt unter DDoS-Schutzmaßnahmen zu stellen, ohne die gesamte Infrastruktur zu beeinträchtigen.

6) Geografische Traffic-Filterung

Konfigurieren Sie Ihre Firewall so, dass Traffic aus nicht relevanten geografischen Regionen blockiert oder priorisiert wird, um den Druck auf Ihre Systeme zu verringern.

Weiterführende Schutzstrategien: Schulungen und Best Practices

DDoS-Angriffe sind nur ein Teil der weiten Bedrohungslandschaft, die Webanwendungen betrifft. Um nachhaltiges Wissen über Sicherheitsmaßnahmen aufzubauen und sich gegen moderne Bedrohungen zu wappnen, empfehlen wir praxisorientierte Intensivtrainings. Diese Trainings decken ein breites Spektrum an Angriffstechniken und Abwehrmechanismen ab und bieten Ihnen die Möglichkeit, gezielt gegen Cyberangriffe vorzugehen.

Fazit: Schutz vor DDoS-Angriffen

DDoS-Angriffe sind eine ernsthafte Bedrohung für Unternehmen und Organisationen weltweit. Mit den richtigen Schutzmaßnahmen und einer durchdachten Reaktionsstrategie können Sie jedoch sicherstellen, dass Ihre Systeme auch bei einem Angriff funktionsfähig bleiben und der Schaden minimiert wird.

Für eine noch tiefere Expertise empfehlen wir ein iSAQB-zertifiziertes Training zur Web-Sicherheit, das Sie mit den notwendigen Fähigkeiten ausstattet, um Ihre Web-Anwendungen effektiv zu schützen.

Quellen

- Spamhaus History (abgerufen am 14.09.2024)

- GitHub DDoS Incident Report (abgerufen am 03.09.2024)