DevOps als Unternehmens-Kultur verändert die agile Software-Entwicklung

DevOps als Unternehmenskultur verändert die agile Softwareentwicklung

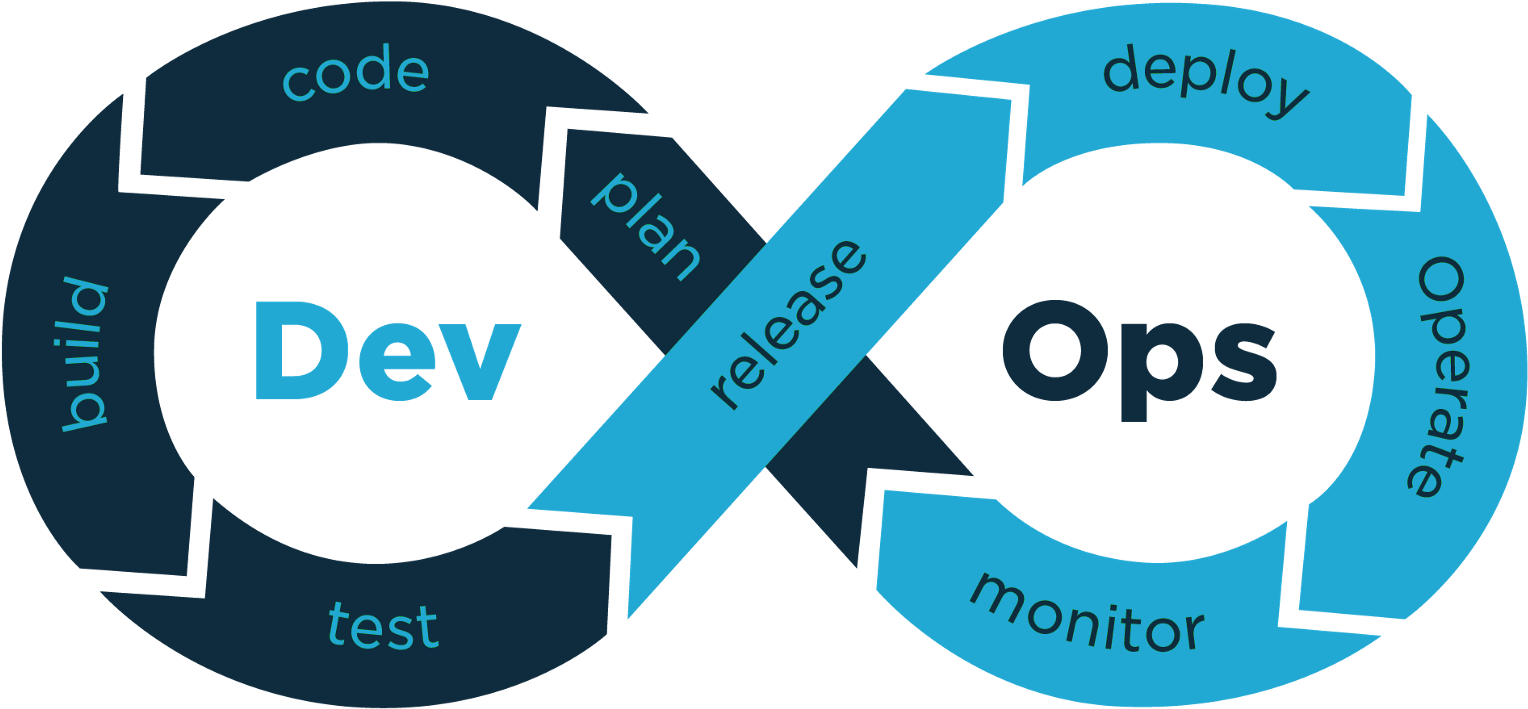

Nach einer Entwicklungsphase jeder Software geht die Anwendung im besten Fall in Produktion und wird eingesetzt und betrieben. DevOps ist eine Kombination der Wörter “Development” und “Operations” und vereint zwei organisatorisch voneinander getrennte IT-Bereiche: die Softwareentwicklung (Dev) und den IT-Betrieb (Ops).

Dadurch kann die Entwicklung hochqualitativer Anwendungen vorangetrieben und einen stabilen, zuverlässigen Betrieb gewährleistet werden.

Ziel von DevOps

DevOps ist hauptsächlich eine Unternehmenskultur und zielt darauf, die Bereiche der Entwicklung und des IT-Betriebs in der modernen Softwareentwicklung zusammenzubringen. Alle Prozesse, die die Entwicklung, den Betrieb und die Auslieferung von Software betreffen, müssen gegebenenfalls angepasst werden. Dies wird durch agile Entwicklungsprozesse (Development, Tests) vereinfacht, der Prozess der Softwareauslieferung (Delivery) wird dann mit aufgenommen.

Durch den DevOps-Ansatz werden Prozesse der Softwareentwicklung und des IT-Betriebs optimiert und automatisiert, damit Software schneller, effizienter und zuverlässiger erstellt, getestet und freigegeben werden kann.

Warum DevOps

Moderne Softwareentwicklung setzt immer mehr auf Agilität und ist bemüht, bestehende Systeme ständig zu optimieren.

Der Betrieb hat hingegen das Ziel, möglichst stabile Software, Infrastrukturen und Systemlandschafen zu betreuen. Somit bleiben beide IT- Bereiche oft isoliert voneinander und jeweils auf eigene Ziele konzentriert. DevOps-Ansatz versucht, beide Bereiche zusammenzubringen, um sowohl eine schnelle und effiziente Entwicklung als auch einen stabilen Betrieb zu gewährleisten. Somit wird der komplette Lebenszyklus einer Softwarekomponente vom selben Team betreut, frei nach dem Motto:

“You build it, you ship it, you run it”.

Bei DevOps geht es darum, eine Brücke zwischen traditionell isolierten Entwicklungs- und operationellen Teams zu schaffen. In diesem Modell arbeiten Entwicklungs- und Betriebsteams von der Entwicklung und dem Test über die Bereitstellung bis hin zum Betrieb zusammen.

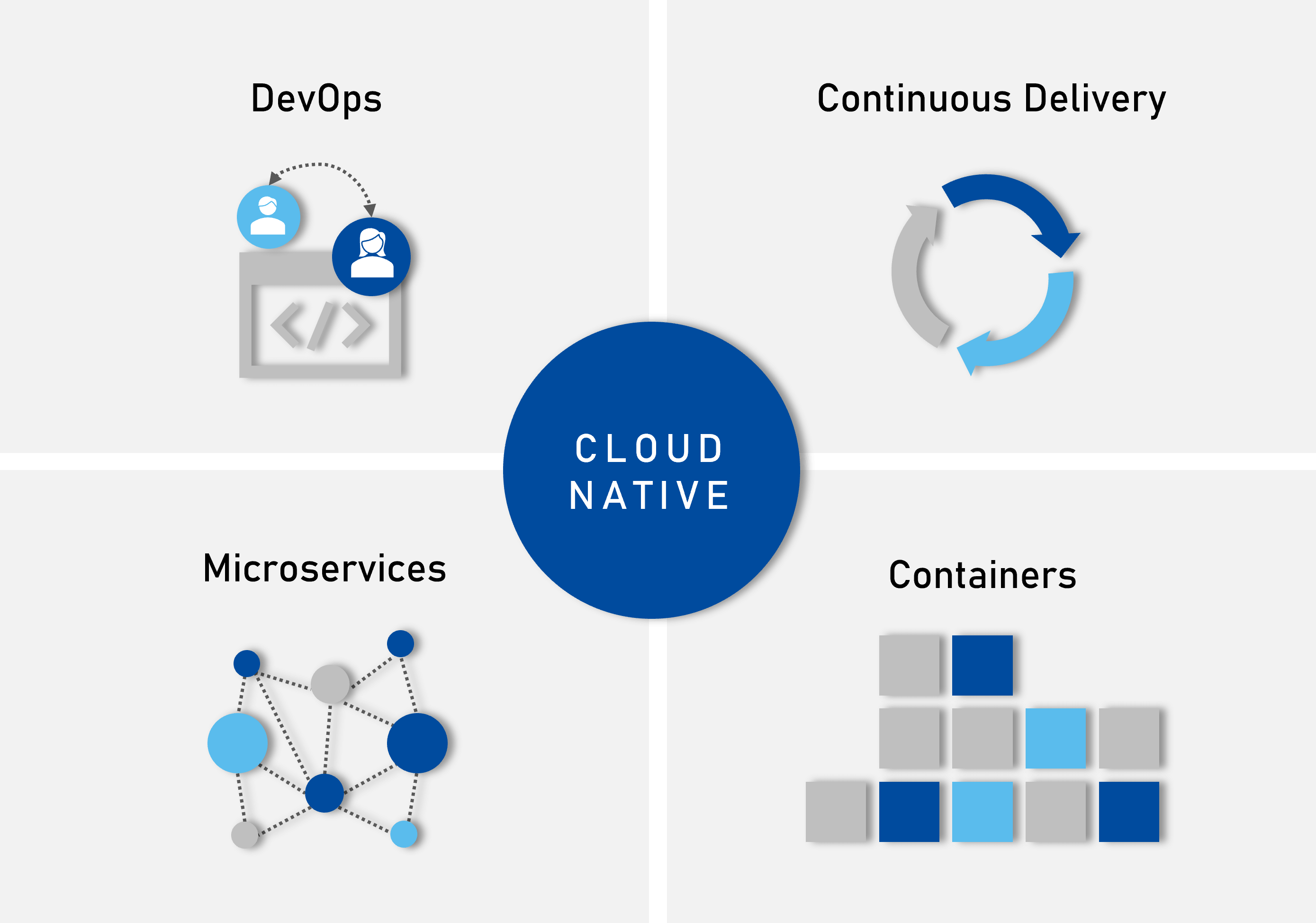

DevOps Komponenten

DevOps gleicht einer “Endlosschleife”, die von der Softwareplanung, über Code-, Build-, Test- und Release-Phasen über die Bereitstellung, den Betrieb, die Überwachung und das Feedback wieder zurück zur Planung zurückführt.

Eine grundlegende DevOps-Praxis besteht darin, sehr häufige, aber kleine Updates inkrementeller Art durchzuführen.

Durch DevOps soll sich das komplette Projektteam gegenseitig unterstützen und Wissen und Erfahrungen über alle Teammitglieder geteilt werden. So sollen Wissensmonopole verhindert werden.

Zu den gängigen und beliebten DevOps-Methoden zählen Scrum, Kanban und Agile.

DevOps Praktiken

- Fortlaufende Entwicklung: Planungs- und Codierungsphasen des Lebenszyklus

- Kontinuierliche Prüfung: durch automatisierte Tests

- Kontinuierliche Integration: Im Kern von kontinuierlicher Integration steht ein Versionsverwaltungssystem, um den Code zu organisieren, Änderungen zu verfolgen und automatisierte Tests zu ermöglichen.

- Kontinuierliche Lieferung: Code-Updates sollten so oft wie möglich bereitgestellt werden, um das kontinuierliche Angebot optimal nutzen zu können. Durch die Freigabe von Codes in kleineren Blöcken werden Engpässe vermieden und ein stetiger, kontinuierlicher Integrations-Fluss gewährleistet.

- Kontinuierliche Bereitstellung: automatische Freigabe von neuem oder geändertem Code in der Produktion. Dies bedarf robuste Test-Frameworks, um sicherzustellen, dass der neue Code fehlerfrei und bereit für die Produktion ist.

- Kontinuierliche Überwachung: fortlaufende Überwachung des sich in der Produktion befindlichen Codes und zugrundeliegender Infrastruktur. Eine Benachrichtigung über Fehler oder Probleme führt zur Entwicklung zurück.

DevOps Vorteile

- Schnelle Entwicklung

- Schnelle Bereitstellung

- Schnelle Reaktion auf Zwischenfälle

- Lieferung qualitativ hochwertiger Software

- Verbesserung der Zusammenarbeit und Kommunikation zwischen den Teams

- Steigerung der Produktivität durch DevOps-Tools

- Schnelle Problemlösung/Fehlerbehebung

- Minimierung von Ausfallzeiten der Anwendung

DevOps – Open source softwares

Die gesamte Prozesskette läuft wie folgt ab:

- Entwickler pushen ihren Code in ein Repository

- Unittests werden ausgeführt

- Packaging + Build

- Automatisierte Integrationstests

- Releasemanagement

- Konfiguration

- Monitoring

Mit den richtigen Tools kann der oben gezeigte Prozess automatisiert werden. In diesem Hinblick haben sich folgende Tools in vielen Unternehmen und Projekten bewährt:

- Docker

- Git

- JUnit

- Jenkins

- Apache Maven

- Selenium

Fazit

Das DevOps-Modell kommt mit einem Umdenken umher: der neue Prozess, der die Entwicklung und den Betrieb vereinen soll, muss erstmal in den Köpfen aller Teammitglieder ankommen. DevOps ermutigt Entwicklungs- und Betriebsteams, über die gesamte Anwendung hinweg, zusammenzuarbeiten. Der IT-Betrieb, der sich eher auf Stabilität der Software stützt und selten neue Deployments durchführt, muss großes Vertrauen im gesamten Prozess bringen, dass Entwicklung und Test ein stabiles Produkt liefern. Dadurch sind häufige Deployments kein Widerspruch zur Stabilität von Anwendungen. Ein weiterer Vorteil bei der Arbeit mit DevOps-Ansatz ist die Geschwindigkeit. Wenn Codeänderungen häufiger und mit geringem Risiko auf negative Auswirkungen auf andere Bereiche oder Komponenten bereitgestellt werden, lassen sich Innovationen dadurch schneller und einfacher realisieren.

Referenzen

- https://mindsquare.de/knowhow/devops/

- https://www.qytera.de/blog/devops-konzept-tools

- https://www.atlassian.com/de/devops/devops-tools

- https://elevatex.de/de/blog/it/was-ist-devops/

- https://www.it-cisq.org/use-cases/devops-code-quality.htm

- https://www.pngkey.com/download/u2e6e6a9o0r5i1y3_devops-is- more-about-technology-than-the-teams/